Wolf-Dieter Batz am 28.6.1984:Überblick 4

|

Wolf-Dieter Batz: „Zur Modellbildung in der Gedächtnisforschung“ |

- Überblick

Die Bezeichnung 'Cognitive Science', die ich im Exkurs (s.o.) mit 'Kognitive Wissenschaften' übersetzt habe, steht an sich nicht für eine Gruppe von Wissenschaften, wie es meine Übersetzung suggerieren könnte. Die Kognitiven Wissenschaften haben entgegen den Neurowissenschaften noch große Berührungsängste untereinander. Als Folge findet eine wirklich interdisziplinäre Arbeit nur innerhalb einzelner Gruppen von Wissenschaftlern statt. Die dort betriebene Disziplin ist jene, auf die das Etikett 'Cognitive Science' angewendet werden darf.

Cognitive Science ist, so betrachtet, eine neue Disziplin innerhalb der Kognitiven Wissenschaften. Eine kurze Beschreibung ihres Entstehungszusammenhangs findet sich z.B. bei Roger C. SCHANK:

"Linguists were not seriously interested in cognition. Psychologists were, but did not take seriously the idea of a computer program as the embodiment of a theory. Computer Science was still nascent and in many ways resistant to the "mushiness" of Artificial Intelligence (AI). Where AI did exist, concern with people as opposed to machines was frequently lacking. In the last few years the situation in all three fields has begun to change. In AI, cognitive concerns have not only been accepted but are considered to be of prime importance. Many linguists have abandoned their overriding concern with syntax for a more balanced view of language phenomena. Psychologists are learning how to build computer models themselves and have begun to run experiments to test hypotheses taken directly from work in AI. What we are seeing is the beginning of Cognitive Science."[1]

Die Anfänge der Cognitive Science liegen SCHANK zufolge also am Ende der siebziger Jahre dieses Jahrhunderts. Innerhalb der sie konstituierenden Disziplinen entstammen die Ansätze einer allgemeinen Gedächtnisforschung zum größten Teil der kognitiven Psychologie.

Diese wiederum kann als Erweiterung des Behaviorismus angesehen werden, nachdem eine große Anzahl experimenteller Befunde sich mittels probabilistischer Assoziationsgesetze allein nicht mehr beschreiben ließ. Es wurde notwendig, dem Individuum eine gewisse, vorläufig aber noch begrenzte, Freiheit bei der Aufnahme von Reizen zuzugestehen.

Die beginnende Entwicklung von elektronischen Anlagen zur Informationsverarbeitung ermöglichte nun auch für die Psychologen eine Horizontverschiebung;[2] ganz langsam entwickelte sich ein sogenannter 'information-processing approach', den ich wie folgt charakterisieren möchte:

- Ein Reiz existiert immer als eine Zweiheit von 'Signal' und 'Nachricht'.

- Es bleibt dann zu klären, w i e dieser Komplex aufgenommen wird.

Zwei Punkte sind dabei von besonderem Interesse:

- was geschieht während der Aufnahme? -> Prozess;

- welche Veränderungen erfährt der Reiz dabei? -> Produkt.

Die beiden Unterpunkte von (ii) sind bei ihrer Erforschung nicht unabhängig voneinander zu behandeln. Ein Modell der Informationsverarbeitung ohne eine Beschreibung des Endzustands stellt billigerweise höchstens ein Fragment dar. Ebenso sind Modelle der Organisation von Gedächtnisinhalten einer gewissen Willkür preisgegeben, solange nichts über die Entstehung der speziellen Organisation ausgesagt wird.

Trotzdem haben sich zwei 'Schulen' konstituiert, die eine weitgehend exklusive Behandlung dieser beiden Bruchstücke betreiben:

- ATKINSON, SHIFFRIN, CRAIK, LOCKHART u.a. repräsentieren in diesem Kapitel die Theoretiker der sogenannten Prozess-Modelle

- ANDERSON, RUMELHART, NORMAN u.a. vertreten die Gruppe der mit der Organisation von Gedächtnisinhalten befaßten Forscher.

Die Ursache dieser Trennung muß nicht unbedingt in einer möglichen Schwäche psychologischer Theoriebildung zu suchen sein; nach meiner Überzeugung liegt sie wesentlich tiefer:

Die Ansätze in allen Bereichen der Cognitive Science beruhen auf der simplen Annahme, man könne durch die Beobachtung von Verhalten an der Oberfläche des Organismus die Mechanismen erschließen, die zu diesem Verhalten führen, und zwar eindeutig!

Eine Folge dieser Annahme besteht zwangsläufig im sogenannten Storage-versus-Retrieval-Dilemma: Kann eine Person z.B. eine bestimmte gelernte Information nicht reproduzieren, so ist prinzipiell nicht entscheidbar, ob nicht gespeichert wurde (Storage), oder ob nicht 'abgerufen' werden kann (Retrieval).

Je nach persönlichen Präferenzen kann ein Forscher sich für den Weg der Information bis zur endgültigen Speicherung, oder für deren Organisation im Speicher interessieren. Letztere dient dann als Erklärung sogenannter 'Retrieval Failures'.

Die computergestützte Simulation von sprachverstehenden Systemen bietet eine Möglichkeit, diese beiden Traditionen in ein umfassenderes Gebilde einzuordnen. Es bleibt aber die Frage der Eindeutigkeit bestehen: Gibt es letzlich nur einen denkbaren Mechanismus oder sind prinzipiell unendlich viele verschiedene denkbar, von denen jeder einen beachtlichen Teil der vorhandenen Empirie erklären kann, und zwar umkehrbar eindeutig?[3]

Betrachtet man die Forschung zur Organisation von Langzeitgedächtnis in den siebziger Jahren, dann lassen sich verschiedene Versuche erkennen, ein wenig Systemaktik in die Vielfalt möglicher Gedächtnisinhalte zu bringen:

- episodisch vs. semantisch

Diese Unterscheidung geht auf einen Vorschlag von Endel TULVING[4] zurück,der damit versuchte, Unterschiede im Gedächtnisbegriff von Storage- und Retrievaluntersuchungen aufzuklären. Kritisches Merkmal für diese Unterscheidung ist die Dimension, entlang der Inhalte miteinander verbunden werden.

- Das episodische Gedächtnis speichert Information entsprechend ihres zeitlichen Auftretens, eben in Episoden.

- Das semantische Gedächtnis verbindet Informationen nach ihrer Bedeutung. Ganz unerheblich ist dabei wann und wo diese aufgenommen wurden.

Sollte diese Trennung sich bewähren, dann hätte man eine Erklärung für die fehlende Konvergenz der beiden oben beschriebenen Ansätze: Es wurden einfach verschiedene Speicher untersucht, die sich billigerweise durch verschiedene Eigenschaften auszeichnen.

Um das Verfahren abzukürzen, kann man auch gleich die Nicht-Konvergenz als Evidenz für eine Trennung von semantischem und episodischem Gedächtnis ansehen!

- prozedural vs. deklarativ

Diese Unterscheidung wird von WINOGRAD[5] als "artificial intelligence incarnation of the old philosophical distinction between 'knowing that' and 'knowing how'" verstanden. In der Künstlichen Intelligenz ist diese Unterscheidung allerdings mehr Standpunktsache als Tatsache, d.h. es gibt keine zwingende Trennung von Daten(deklaratives Wissen) und Programm (prozedurales Wissen). Bezogen auf menschliches Gedächtnis sieht das Ganze etwas anders aus:

Das deklarative Wissen entspricht hier dem verbalisierbaren Bereich des Gedächtnisses, während prozedurales Wissen sich auf motorische Muster bezieht, die nur durch Benutzung zugänglich sind.[6]

Ein Computer dagegen kann prinzipiell alles, was er an Software enthält, einem 'Output-Device' übergeben, d.h. verbalisieren.

Der Übergang vom Black-Box- zum Information-Processing-Ansatz läßt sich auch an der Wandlung angewandter Paradigmen erkennen. Der Term 'aufnehmen' weicht dem Term 'enkodieren', und interne Prozesse spielen zunehmend wichtige Rollen. Sechs der populärsten Paradigmen will ich kurz beschreiben:

- Paradigmen

- serielles Lernen (SL): Dieses Paradigma kommt ohne Schwierigkeiten mit dem Term aufnehmen aus: Eine Liste von sinnlosen Silben wird solange wiederholt, bis sie fehlerfrei reproduziert werden kann. Diese Methode geht genau wie die sinnlosen Silben auf EBBINGHAUS[7] zurück.

- Paarassoziations-Lernen (PAL): Dieses Paradigma stellt ebenfalls ein Relikt des Behaviorismus dar. Es läßt sich am besten analog zum Vokabellernen auffassen. Allein durch naive Introspektion lassen sich drei Phasen identifizieren:

- das erste Wort des Paares muß gelernt werden;

- das zweite Wort muß ebenso gelernt werden;

- die Verbindung zwischen diesen beiden Worten muß hergestellt werden.

- Transfer: Beim Transfer wird untersucht, wie sich gelernte Wortpaare auf das Lernen von ähnlichen Paaren auswirken. Dazu gehören vor allem die Spezialfälle der proaktiven und der retroaktiven Hemmung#. Bei Beachtung der Phasen des PAL lassen sich so bereits Hypothesen über verschiedene interne Prozesse formulieren und testen.

- free Recall (FR): Dieses Paradigma entspricht im Prinzip dem SL. Der Unterschied besteht darin, daß im FR die Items bereits nach dem ersten Lerndurchgang (single-trial-) bzw. nach mehreren Durchgängen (multi-trial-free-recall) reproduziert werden sollen. Das Maß ist dann nicht die Anzahl nötiger Durchgänge, sondern der Anteil von falschen oder fehlenden Items. Diese kleine Variation ermöglicht z.B. Aufschluß darüber, wie die Items intern organisiert sind: Werden Ähnlichkeiten benutzt, d.h. spielen phonetische Merkmale eine Rolle usw.

- Wiedererkennen (recognition): Dieses Paradigma läßt sich als abgeschwächte Form des vorigen begreifen. Legt man beim FR eine Produktions- und eine Evaluationsphase zugrunde, so entfällt die erste im Falle des Wiedererkennens: Es braucht nur evaluiert zu werden.

- cued Recall (cR): Eine weitere Möglichkeit, etwas über die interne Organisation gelernten Materials zu erfahren, bietet diese Mischung aus Wiedererkennen und FR. Den Pbn werden potentielle Schlüsselworte vorgegeben, die das Reproduzieren erleichtern sollen.

Aufschluß erwartet man dabei von der Beziehung zwischen Items und erfolgreichen Cues.

Aus allem bisher Gesagten ergibt sich eine grobe Dreiteilung dieses Kapitels:

- Der folgende Abschnitt (b) wird in seinen Teilabschnitten die Modelle abhandeln, die sich dem (Langzeit)-Gedächtnis[8]

über die an seiner Bildung beteiligten Prozesse zu nähern versuchen. Die Abfolge der Teilabschnitte (b¦-b+) wird sich, sofern dies möglich sein wird, in positiver Richtung entlang der Komplexitäts-Dimension orientieren. Im Idealfall sollte dies einer chronologischen Anordnung gleichkommen.

- Abschnitt (c) behandelt die Modelle, welche sich mit der Struktur des Langzeitgedächtnisses befassen. Notgedrungen wird sich dabei die Aufmerksamkeit auf semantische Netzwerke beschränken. Entsprechend der Unterscheidung von Struktur und Organisation[9] soll vor allem geprüft werden, ob diese Ansätze als Modelle für die Organisation permanenter Spuren brauchbar sind, oder ob es sich lediglich um systematisierte Paraphrasierungen empirisch vorgefundener Strukturen handelt.

- Die letzten Abschnitte (d,e) schließlich behandeln zwei Modelle aus der Cognitive Science.

Entsprechend SCHANKs (s.o.) Beschreibung handelt es sich bei dieser Disziplin um ein Konglomerat von Linguistik, AI[10] und kognitiver Psychologie. Ein Effekt dieser Synthese ist sicher die Funktionsmetamorphose des Digitalrechners von der Metapher zum Werkzeug.

Ob sich diese Wandlung als ein Fortschritt in der Modellbildung bemerkbar macht, ist in diesem Abschnitt Zentrum des Interesses.

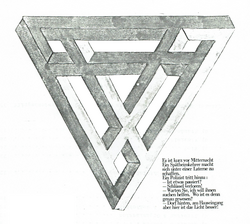

Die Anordnung dieser drei Abschnitte entspricht den Enden eines auf dem Kopf stehenden Ypsilons, das ganz nebenbei zum Sinnbild einer Wissenschaft mit exzessivem Theorienpluralismus geradezu prädestiniert ist:

Die beiden unteren Äste symbolisieren jeweils die Prozeß- und die Organisationstradition. Diese konvergieren zum Knoten im Zentrum, von wo aus sich der Ast der Cognitive Science nach oben ausstreckt.

Diese Gesamtkonfiguration dient als Legitimation, alle in diesem Kapitel behandelten Ansätze unter das Etikett Cognitive Science zu subsummieren.

Diplomarbeit "Zur Modellbildung in der Gedächtnisforschung" bei Dr. A.Metraux, Prof. HJ Ahrens und Prof. M.Zimmermann

- ↑ Schank,R.C. (1980): Language and memory. S.243 f.

- ↑ selbstverständlich im Sinne einer Erweiterung!

- ↑ vgl. hierzu die Position von S.P.R. Rose im Exkurs.

- ↑ vgl. Tulving,E. (1972): Episodic and semantic memory.

- ↑ Winograd,T. (1975): Frame representations and the declarative/procedural controversy.

- ↑ vgl. Kap.3: 'Wo?'

- ↑ vgl. Kap.2: 'Wieviel'

- ↑ vgl. Kap.1: 'Wahrnehmung & Gedächtnis'

- ↑ vgl. Kap.1: 'Struktur & Organisation'

- ↑ AI bedeutet 'artificial intelligence' = Künstliche Intelligenz